Tehnologija prepoznavanja govora i jezika je oblast koja se brzo razvija, što je dovelo do pojave novih sistema govornih dijaloga. Jedan od primjera su Amazon Aleksa i Siri. Značajna prekretnica u razvoju dijaloških sistema vještačke inteligencije je dodavanje emocionalne inteligencije. Sistem koji je u stanju da prepozna emocionalna stanja korisnika, pored razumijevanja jezika, stvorio bi empatičniji govor.

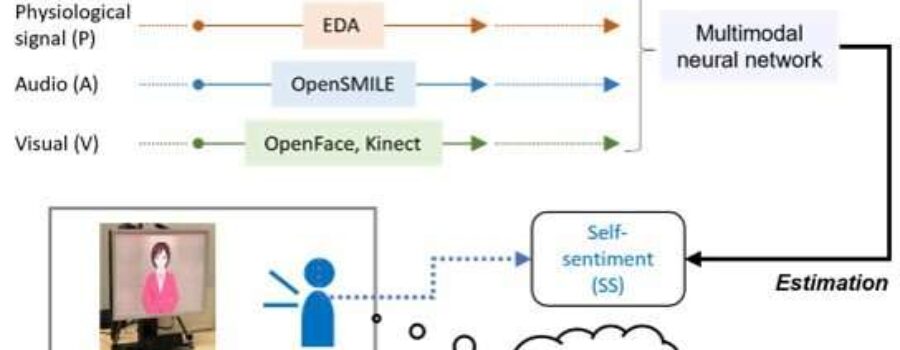

“Multimodalna analiza sentimenta“, je grupa metoda koje predstavljaju zlatni standard za vještačku inteligenciju, sistem dijaloga sa detekcijom osjećanja. Ove metode mogu automatski analizirati psihološko stanje osobe na osnovu njenog govora, boje glasa, izraza lica, i ključne su za sisteme emocionalne inteligencije usmjerene na čovjeka. Ova tehnika bi potencijalno mogla da realizuje emocionalno inteligentnu vještačku inteligenciju sa nadljudskim sposobnostima, koja razumije osjećanja korisnika i generiše odgovor u skladu sa tim.

U novom istraživanju, objavljenom u časopisu IEEE Transactions on Affective Computing, fiziološki signali su prvi put dodati multimodalnoj analizi sentimenta od strane istraživača iz Japana. Kolaborativni tim čiji je član vanredni profesor Šogo Okada sa japanskog Naprednog instituta za nauku i tehnologiju (JAIST) i profesor Kazunori Komatani sa Instituta za naučna i industrijska istraživanja na Univerziteta Osaka, rekli su da su ljudi dobri u prikrivanju osjećanja. Samim tim, unutrašnje emocionalno stanje korisnika nije uvijek tačno oslikano dijalogom, ali pošto je ljudima teško da svjesno kontrolišu svoje biološke signale, kao što je puls, to može biti korisno za procjenu njihovog emocionalnog stanja. Okada je pojasnio da bi ovo moglo da dovede do poboljšanja procjene sposobnosti osjećanja koja su izvan ljudskih.

Tim je analizirao 2.468 primjera dijaloga vještačke inteligencije od 26 učesnika, da bi procijenio nivo uživanja koje je korisnik doživio tokom razgovora. Zatim im je zatraženo da daju procjene koliko im je razgovor bio dosadan ili prijatan. Tim je koristio multimodalni skup podataka za dijalog pod nazivom „Hazumi1911“, koji je na jedinstven način kombinovao prepoznavanje govora, senzore boje glasa, izraz lica i detekciju držanja, kao oblik fiziološkog signala govora.

Nakon poređenja odvojenih izvora informacija, informacije o biološkom signalu su se pokazale efikasnijim od glasa i izraza lica, rekao je Okada. Zatim su kombinovali informacije o jeziku sa informacijama o biološkom signalu da bi procijenili unutrašnje stanje tokom razgovora sa sistemom. Učinak vještačke inteligencije nakon toga postao je uporediv sa ljudskim.

Ovaj sistem sugeriše da bi otkrivanje fizioloških signala kod ljudi, koji obično ostaju skriveni od nas, moglo otvoriti put emocionalno inteligentnim sistemima dijaloga, zasnovanim na vještačkoj inteligenciji. To bi činilo prirodniju interakciju između čovjeka i mašine.

Štaviše, emocionalno inteligentni sistemi vještačke inteligencije mogli bi pomoći pri identifikaciji i praćenju mentalnih bolesti, tako što će osjetiti promjenu u svakodnevnim emocionalnim stanjima.

Izvor: techexplore.com